Скидка 10% на курс!

Reinforcement Learning

Научим внедрять RL-алгоритмы на практике в играх, робототехнике, энергетике и финансах

Advanced

Онлайн

Для кого этот курс?

- Для ML-инженеров, которые хотят научиться внедрять RL в продакшн: оптимизация систем, алгоритмический трейдинг, управление ресурсами. А также стремятся к эффективному развертыванию и масштабированию RL-моделей

- Для специалистов по Data Science, которые используют RL для задач, где классический ML неэффективен — адаптивные системы, динамические среды. А также интересуются комбинацией RL с NLP, рекомендательными системами

- Для Fullstack-разработчиков, которые хотят освоить RL для создания интеллектуальных приложений — от игровых AI до автоматизации процессов или перейти в ML-направление

- Для системных аналитиков, которые изучают RL, чтобы проектировать AI-решения для бизнеса: автоматизация процессов, логистика, финансы. А также хотят понимать возможности и ограничения RL для принятия решений

- Для Deep Learning инженеров, которые работают с Deep RL в сложных доменах — робототехника, игровые AI, компьютерное зрение, и нацелены на research и передовые гибридные архитектуры

Необходимые знания:

- базовое знакомство с Python

- базовые знания линейной алгебры (матрицы, векторы, градиентный спуск)

- базовые навыки работы с ML (pandas, sklearn, линейная регрессия, логистическая регрессия)

Что такое Reinforcement Learning?

Reinforcement Learning — это одна из трех основных парадигм машинного обучения, в котором агент учится взаимодействовать с окружающей средой методом проб и ошибок. Reinforcement Learning можно использовать в разных областях:

-

В играх, чтобы создавать ботов, которые могут победить даже лучших игроков.

-

В робототехнике, чтобы роботы могли учиться и улучшать свои навыки без постоянного программирования.

-

В финансах, чтобы создавать алгоритмы, которые могут сами покупать и продавать активы и приносить прибыль.

-

В электронной коммерции, чтобы создавать системы, которые предлагают товары, которые нравятся покупателям.

-

В промышленности, чтобы оптимизировать работу заводов и снизить расход энергии.

Что вам даст этот курс?

Вы научитесь:

-

Понимать, как работает обучение с подкреплением, и применять классические алгоритмы типа Q-learning, SARSA и Monte Carlo.

-

Создавать модели окружения и обучать агентов RL для решения задач в ваших условиях.

-

Использовать нейронные сети в RL и применять алгоритмы Deep RL, от самых простых, таких как DeepQ-Network (DQN) до самых сложных, таких как Proximal policy optimization (PPO).

-

Использовать продвинутые методы RL, такие как оптимальное управление, обучение со скользящим горизонтом и Model-based RL, для сложных задач.

-

Решать конкретные задачи с помощью RL и понимать, как это работает на практике.

Вы сможете:

-

Создавать ботов и NPC для игр, которые будут обучаться и подстраиваться под игрока, делая игру интереснее и неожиданнее.

-

Делать роботов, которые смогут сами ориентироваться в пространстве, двигать предметы и выполнять задачи в разных условиях.

-

Создавать алгоритмы, которые будут автоматически торговать на финансовых рынках, анализируя данные и принимая решения о покупке и продаже, чтобы заработать побольше и не рисковать.

-

Делать персонализированные рекомендации, которые будут учитывать вкусы пользователей и предлагать им подходящие товары, услуги или контент.

-

Решать разные задачи по оптимизации и управлению в разных сферах: от производства до энергопотребления. RL поможет автоматизировать процессы и сделать их эффективнее.

NOTE! По итогу большинства вебинаров вы получаете Jupyter Notebook с разбором практического кейса по материалам занятий.

Почему стоит освоить?

Процесс обучения

Обучение проходит онлайн: вебинары, общение с преподавателями и вашей группой в Telegram, сдача домашних работ и получение обратной связи от преподавателя.

Вебинары проводятся 2 раза в неделю по 2 ак. часа и сохраняются в записи в личном кабинете. Вы можете посмотреть их в любое удобное для вас время.

В ходе обучения вы будете выполнять домашние задания. Каждое из них посвящено одному из компонентов вашего выпускного проекта.

После выполнения всех домашних заданий вы получите готовый выпускной проект.

Оптимальная нагрузка

Возможность совмещать учебу с работой.Эксперты

Преподаватели из разных сфер, каждый со своим уникальным опытом.

Перспективы

Получите знания, которые помогут повысить вашу востребованность и доход.

Карьерная поддержка

- Карьерные мероприятия в сообществе

Публичный разбор резюме

Публичное прохождение собеседования и воркшопы - Разместите свое резюме в базе OTUS и сможете получать приглашения на собеседования от партнеров

Формат обучения

Интерактивные вебинары

2 занятия по 2 ак.часа в неделю.

Доступ к записям и материалам остается навсегда.

Обратная связь

Домашние задания с поддержкой и обратной связью наших преподавателей помогут освоить изучаемые технологии.

Активное комьюнити

Чат в Telegram для общения преподавателей и студентов.

Программа

Введение в Reinforcement Learning

Модуль начинается с общего введения, охватывает ключевые особенности обучения с подкреплением, основные алгоритмы. Вы рассмотрите, как построить модель окружения и агента, и примените свои знания на простых сценариях.

Тема 1: Знакомство с Reinforcement Learning

Тема 2: Ключевые понятия RL: агент, среда, награда, политика. Построение среды

Тема 3: Основные алгоритмы RL: Value based

Тема 4: Основные алгоритмы RL: Policy based

Deep Reinforcement Learning

В этом модуле вы рассмотрите введение в глубокое обучение с подкреплением, которое объясняет значимость глубоких Q-сетей, представляет алгоритмы на основе политик. Затем объединяет методы на основе политик и значений с использованием алгоритма Actor-Critic. И, наконец, охватывает то, как нейронные сети могут использоваться для аппроксимации функций вознаграждения и политик.

Тема 1: Введение в Deep Reinforcement Learning

Тема 2: Deep Q-Network (DQN) алгоритм

Тема 3: Deep Policy Gradient (PG) алгоритм

Тема 4: Actor-Critic алгоритм

Тема 5: TRPO -> PPO

Тема 6: DDPG -> TD3 -> LSTM-TD3

Advanced Reinforcement Learning

Модуль содержит более сложные темы и глубже раскрывает пройденный материал. Здесь рассматривается применение алгоритмов к более сложным ситуациям, например наличие фиксированных правил (model-based) или взаимодействие нескольких агентов между собой для достижения общей темы.

Тема 1: Обучение с использованием модели среды (model-based rl)

Тема 2: Model-based, часть 2

Тема 3: Иерархическое обучение с подкреплением

Тема 4: Выбор темы и организация проектной работы

Тема 5: Многоагентное обучение и кооперация агентов

Тема 6: Трансформеры в RL: decision transformers и action transformers

Применение RL в реальных задачах

Модуль посвящен обзору практических примеров применения RL. Вы познакомитесь с игровой индустрией и рассмотрите какие задачи здесь можно решать с помощью RL. Поговорите о робототехнике, поймете какое применение RL находит в рекомендательных системах и более подробно рассмотрите финансовые модели на примере задачи балансировки портфеля активов и задачи кредитного скоринга.

Тема 1: Применение RL в игровой индустрии

Тема 2: Применение RL в робототехнике

Тема 3: RL в рекомендательных системах

Тема 4: RL в задаче скоринга

Тема 5: Применение RL в управлении финансовым портфелем

Проектная работа

Заключительный месяц курса посвящен проектной работе. Свой проект — это то, над чем интересно поработать слушателю. То, что можно создать на основе знаний, полученных на курсе. При этом не обязательно закончить его за месяц. В процессе написания по проекту можно получить консультации преподавателей.

Тема 1: Консультация по проектам и домашним заданиям

Тема 2: Предзащита

Тема 3: Защита проектных работ. Подведение итогов курса

Также вы можете получить полную программу, чтобы убедиться, что обучение вам подходит

Проектная работа

Последний месяц отводится для проектной работы. Студенты могут выбрать одну из сфер, где будут реализовывать алгоритмы обучения с подкреплением:

- игровая индустрия

- робототехника

- управление энергетическими системами

- управление финансовым портфелем

- Построение RecSys на основе алгоритмов машинного обучения с подкреплением (YouTube)

Преподаватели

Эксперты-практики делятся опытом, разбирают кейсы студентов и дают развернутый фидбэк на домашние задания

Прошедшие

мероприятия

Этот курс может оплатить ваш работодатель

- Подробно расскажем об интересующем вас курсе

- Объясним, как договориться с работодателем

- Сообщим стоимость обучения и варианты оплаты

- Ответим на вопросы

- Предоставим шаблон договора и счёт на оплату

Отзывы

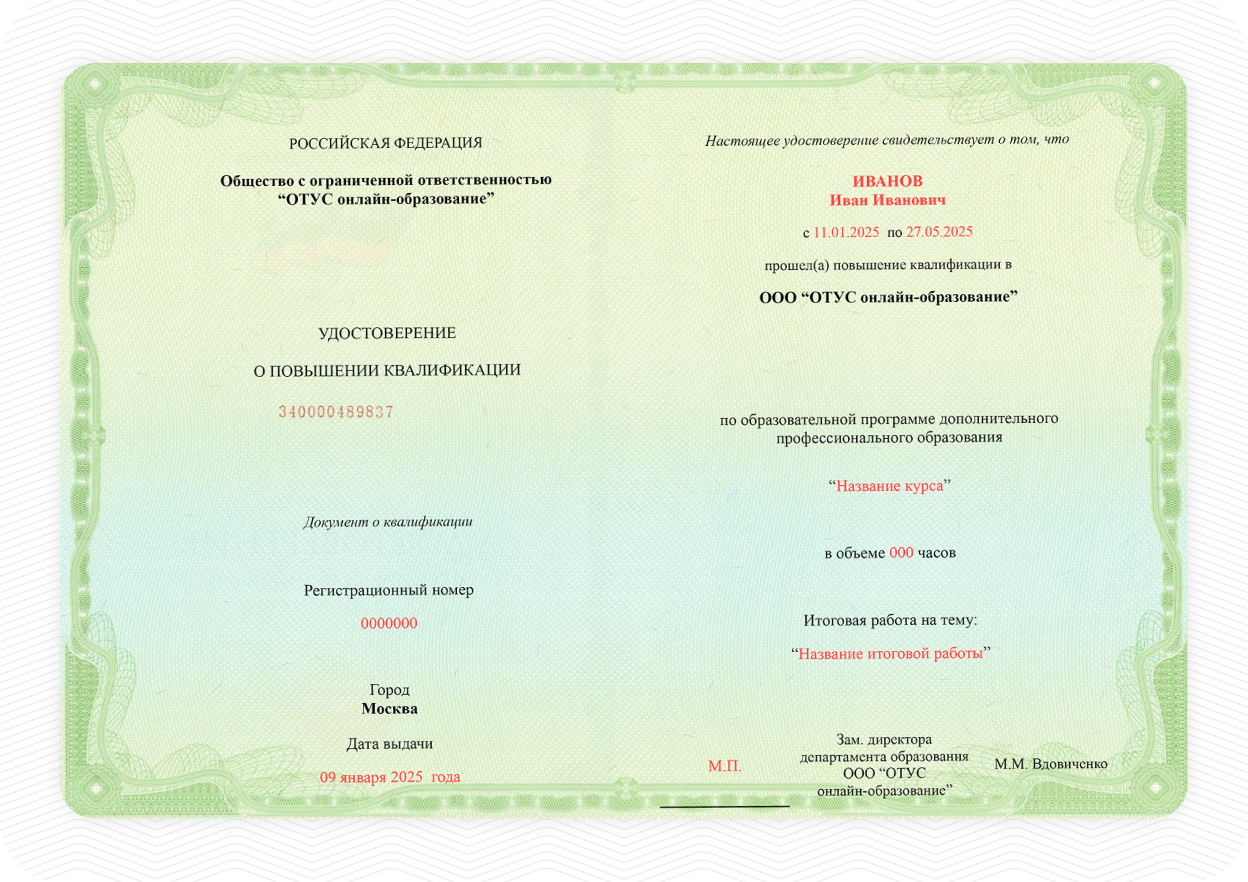

Подтверждение знаний и навыков

OTUS осуществляет лицензированную образовательную деятельность. Вы получите сертификат о прохождении обучения, а также можете получить удостоверение о повышении квалификации.

После обучения вы:

-

Удостоверение о повышении квалификации: если вы успешно защитили выпускной проект и готовы предоставить копию документа о высшем или среднем профессиональном образовании

-

Доступ к учебным материалам курса

-

Ваш личный проект, который поможет проходить собеседования